Objectifs du Projet.

Arobas Technologies souhaite faire évoluer ses ressources HPC autour de 2 axes directeurs :

Ajout d’un nœud « hyper fréquence » pour les applicatifs dont les calculs restent fortement séquentiels ou alors quand le coût des licences devient trop important pour débloquer l’ensemble des cœurs des CPU récents.

Mise à niveau du stockage distribué (système de fichiers parallèles) pour le scratch (=fichiers temporaires d’écriture) pour ne pas limiter les calculs fortement parallèles.

La capacité initiale d’une vingtaine de Téraoctets devait être facilement extensible, simple à appréhender ou à gérer et s’intégrer dans les ressources actuelles administrées en interne à l’aide de Bright Cluster Manager.

Depuis 2017, BeeGFS est intégré dans Bright et ses performances sont extrêmement élevées si le design est correctement effectué.

La mise à jour complète de notre infrastructure HPC a été d’une très grande efficacité, la nouvelle version de Bright (v8) ainsi que le stockage BeeGFS sur notre cluster ont été déployés en seulement 3 jours. C’était une opération critique, car nos ressources étaient indisponibles pendant cette période. La planification à laquelle nous avons participé s’est avérée pertinente et l’arrêt des services a été maîtrisé de bout en bout.

Jacky Verguet, PDG, Arobas Technologies

Solution.

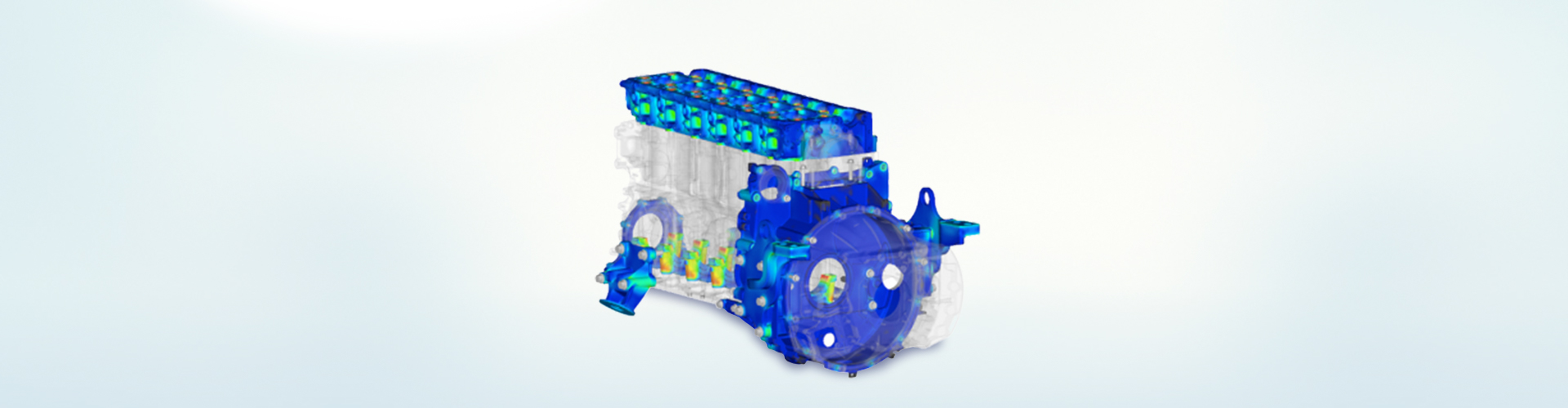

Une machine overclockée a été construite par FRA-SYS sur la base d’un CPU Intel i9 qui permet à Arobas Technologies d’utiliser jusqu’à 18 cœurs de calcul surcadencés à presque 4.2 GHz. Le gain en performances peut dépasser les 40% en comparaison de serveurs Biprocesseurs sur certains applicatifs.

Une nouvelle solution de stockage BeeGFS a été mise en place en même temps que la mise à jour de Bright Cluster Manager. Le matériel a été choisi spécifiquement dans le catalogue Supermicro : un châssis dense (2U) qui propose à la fois 12 emplacements pour disques durs capacitifs (9x HDD 2To en RAID0, capacité nette d’environ 16.7 To) et/ou très rapides (3x SSD 240 Go en RAID5) mais aussi deux emplacements dédiés pour 2x SSD (2x SSD 240 Go en RAID1 pour le système d’exploitation). Ce nœud de stockage bénéficie aussi de 128 Go de mémoire et d’un CPU 8 cœurs. L’interconnexion avec les serveurs existants se fait au travers du réseau dédié hautes performances Infiniband. Dans le but d’optimiser la configuration sur le nœud de stockage BeeGFS, plusieurs instances ou « target » ont été définies : une pour le stockage et une autre séparée pour les métadatas nécessaires à l’accès en parallèle par l’ensemble des nœuds de calcul du cluster existant (9 nœuds de calcul en tout).

Afin de pérenniser cet investissement structurant, un contrat de support BeeGFS a été souscrit pour 3 ans au travers de Bechtle en tant que partenaire certifié niveau GOLD de cette solution ainsi que la prolongation du contrat de support avec Bright Computing.

Bénéfices de la solution.

Les ressources HPC ont été mises en valeur au travers de cette double évolution : logicielle sur la partie Bright Cluster Manager (passage à la nouvelle version 8.1) et matérielle avec la fourniture d’une nouvelle solution de stockage parallèle : BeeGFS.

En conclusion, toutes les machines peuvent écrire et lire de manière concurrentielle sur le nœud de stockage sans aucun facteur négatif dit « d’entonnoir ». L’architecture reste de plus complètement extensible sans futur arrêt de production sur le stockage.