Contattateci.

NVIDIA – Migliore performance per l’Intelligenza Artificiale.

Per trarre vantaggio dall'Intelligenza Artificiale è necessaria un'ampia capacità di elaborazione. Un sistema potente che soddisfa questi requisiti è NVIDIA® DGX™, che si basa su GPU NVIDIA, una piattaforma estremamente performante. La particolarità: NVIDIA DGX fornisce alle aziende software ottimizzato per GPU e gestione semplificata in un sistema compatto.

I vantaggi di DGX Station e DGX Server:

Soluzione software e hardware integrata.

Basato sulla tecnologia NVIDIA ™-Tensor Core per accelerare IA e HPC.

Deep learning training, inferenza e accelerazione di analisi in un unico sistema.

Prestazioni mai raggiunte per iterazioni e innovazioni più rapide.

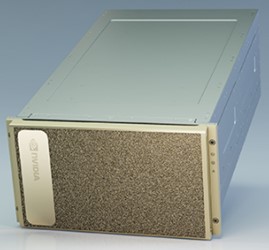

NVIDIA DGX™ A100 è il sistema universale per tutti i carichi di lavoro IA, che offre una densità di calcolo, prestazioni e flessibilità senza precedenti nel primo sistema IA da 5 petaFLOPS al mondo. NVIDIA DGX A100 presenta l'acceleratore più avanzato al mondo, il processore NVIDIA A100 Tensor Core, che permette alle organizzazioni di consolidare formazione, inferenza e analisi in un'infrastruttura IA unificata e facile da implementare con accesso diretto agli esperti IA NVIDIA.

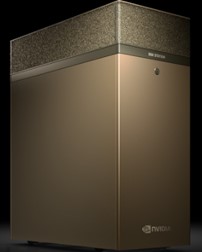

NVIDIA® DGX Station A100 è il sistema compatto, in formato workstation, che offre le tecnologie più recenti, una rapida distribuzione e un'incredibile potenza di calcolo locale. Per sostenervi nel lavoro sono stati integrati un sistema di raffreddamento silenzioso e una serie di strumenti per accelerare lo sviluppo.

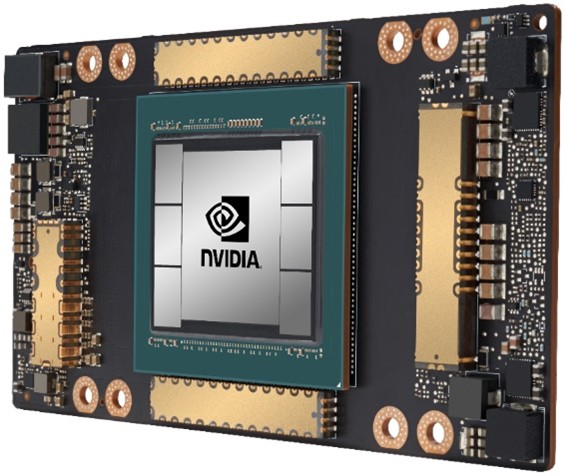

Un processore particolarmente adatto all'Intelligenza Artificiale: NVIDIA® A100 offre un'accelerazione senza precedenti in ogni ordine di grandezza nei campi Deep Learning Training, Deep Learning Inferenz, analisi dei dati e HPC.

Con l'unità di calcolo Tensor di terza generazione, la nuova architettura Ampere consente un aumento delle prestazioni di 20 volte nell'ambiente IA, mentre la nuova funzionalità Multi Instance GPU (MIG) consente e ottimizza la distribuzione del carico di lavoro su un massimo di sette istanze, permettendo ai team di data science di lavorare nel modo più efficiente possibile.

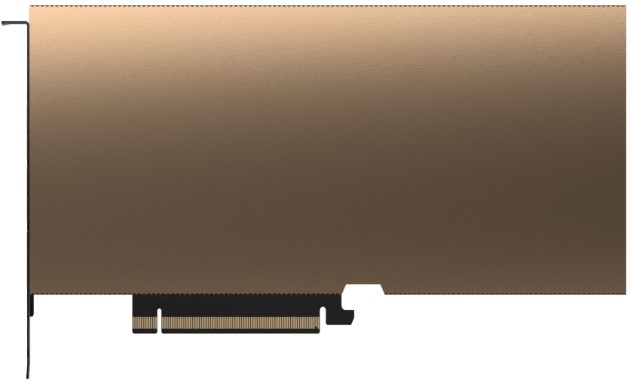

La NVIDIA® T4 con il suo fattore di forma compatto è un tuttofare. Questo acceleratore offre una densità e una flessibilità molto elevate. Ottimizzato per l'inferenza su Deep Learning, il che lo rende un complemento ideale per i sistemi di Deep Learning Training.

Nell'area grafica, il T4 offre un'esperienza utente nativa per i desktop virtuali nell'campo Office e per le stazioni di lavoro virtuali nel segmento midrange CAD.

Per consentire le migliori prestazioni possibili per le workstation virtuali, la NVIDIA® A40 è la scelta migliore di oggi. Questo acceleratore offre prestazioni sufficienti per applicazioni altamente esigenti, come CAD, simulazioni, realtà virtuale e permette anche il rendering in tempo reale per un risultato fotorealistico.

Choose the right NVIDIA Data Center GPU

Workload

| Description | NVIDIA A100 SXM4 | NVIDIA A100 PCIe | NVIDIA T4 | NVIDIA A40 |

| World's Most Powerful Data Center GPU | Versatile Data Center GPU for Mainstream Computing | World's Most Powerful Data Center GPU for Visual Computing | ||

Deep Learning Training | For the absolute fastest model training time | 8-16 GPUs | 4-8 GPUs |

|

|

Deep Learning Inference | For batch and real-time inference | 1 GPU w/ MIG | 1 GPU w/ MIG | 1 GPU |

|

HPC / AI | For scientific computing centers and higher ed and research institutions | 4 GPUs with MIG for | 1-4 GPUs with MIG for |

|

|

Render Farms | For batch and real-time rendering |

|

|

| 4-8 GPUs |

Graphics | For the best graphics performance on professional virtual workstations |

|

| 2–8 GPUs for mid-range | 4-8 GPUs for highest |

Enterprise Acceleration | Mixed Workloads – Graphics, ML, DL, analytics, training, inference | 1-4 with MIG for compute intensive | 1-4 GPUs with MIG for | 4-8 GPUs for balanced | 2-4 GPUs for graphics |

Edge Acceleration | Edge solutions with differing use cases and location |

| 1-2 GPU with MIG | 1-8 GPUs for inference | 2-4 GPUs for graphics |

Workload

| Description | NVIDIA A100 SXM4 | NVIDIA A100 PCIe |

| World's Most Powerful Data Center GPU | ||

Deep Learning Training | For the absolute fastest model training time | 8-16 GPUs | 4-8 GPUs |

Deep Learning Inference | For batch and real-time inference | 1 GPU w/ MIG | 1 GPU w/ MIG |

HPC / AI | For scientific computing centers and higher ed and research institutions | 4 GPUs with MIG for | 1-4 GPUs with MIG for |

Render Farms | For batch and real-time rendering |

|

|

Graphics | For the best graphics performance on professional virtual workstations |

|

|

Enterprise Acceleration | Mixed Workloads – Graphics, ML, DL, analytics, training, inference | 1-4 with MIG for compute intensive | 1-4 GPUs with MIG for |

Edge Acceleration | Edge solutions with differing use cases and location |

| 1-2 GPU with MIG |

Workload

| Description | NVIDIA T4 | NVIDIA A40 |

| Versatile Data Center GPU for Mainstream Computing | World's Most Powerful Data Center GPU for Visual Computing | |

Deep Learning Training | For the absolute fastest model training time |

|

|

Deep Learning Inference | For batch and real-time inference | 1 GPU |

|

HPC / AI | For scientific computing centers and higher ed and research institutions |

|

|

Render Farms | For batch and real-time rendering |

| 4-8 GPUs |

Graphics | For the best graphics performance on professional virtual workstations | 2–8 GPUs for mid-range | 4-8 GPUs for highest |

Enterprise Acceleration | Mixed Workloads – Graphics, ML, DL, analytics, training, inference | 4-8 GPUs for balanced | 2-4 GPUs for graphics |

Edge Acceleration | Edge solutions with differing use cases and location | 1-8 GPUs for inference | 2-4 GPUs for graphics |

*campi obbligatori

Vi preghiamo di prendere visione delle nostre Informazioni sulla protezione dei dati, che vi informeranno in modo dettagliato sul nostro trattamento dei dati e sui vostri diritti in materia di protezione dei dati.