Neem dan contact met ons op.

NVIDIA –

de beste prestaties voor AI.

Om de voordelen van kunstmatige intelligentie te kunnen gebruiken, zijn er uitgebreide rekenprestaties nodig. Een krachtig systeem dat aan deze eisen voldoet, is NVIDIA® DGX™. Het baseert op het high perfomance NVIDIA GPU-platform. Het unieke: NVIDIA DGX biedt organisaties GPU-geoptimaliseerde software en vereenvoudigd beheer – en dat in een compact systeem.

De voordelen van DGX Station en DGX Server:

Geïntegreerde hardware en software.

Gebaseerd op de Tensor Core-technologie van NVIDIA™ ter versnelling van AI en HPC.

Deep learning-training, inferentie en versnelling van analyses in één systeem.

Ongeëvenaarde prestaties voor snellere iteraties en innovaties.

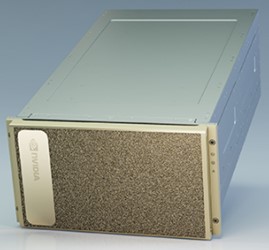

NVIDIA DGX™ A100 is het universele systeem voor alle AI-workloads en biedt ongekende computing dichtheid, prestaties en flexibiliteit in 's werelds eerste 5 petaFLOPS AI-systeem. NVIDIA DGX A100 heeft 's werelds meest geavanceerde versneller, de NVIDIA A100 Tensor Core graphics processor, waarmee organisaties trainingen, inferenties en analyses kunnen consolideren in één uniforme, eenvoudig te implementeren AI-infrastructuur met directe toegang tot NVIDIA AI-experts.

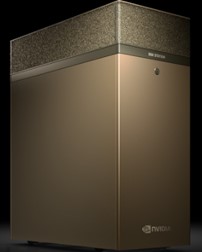

NVIDIA® DGX Station A100 is een compact systeem met het formaat van een workstation en biedt actuele technologieën, een snelle beschikbaarstelling en ongelooflijke lokale rekenprestaties. Om jou te ondersteunen tijdens je werk, is een fluisterstil koelsysteem geïntegreerd en staan er vele tools ter beschikking voor een versnelde ontwikkeling.

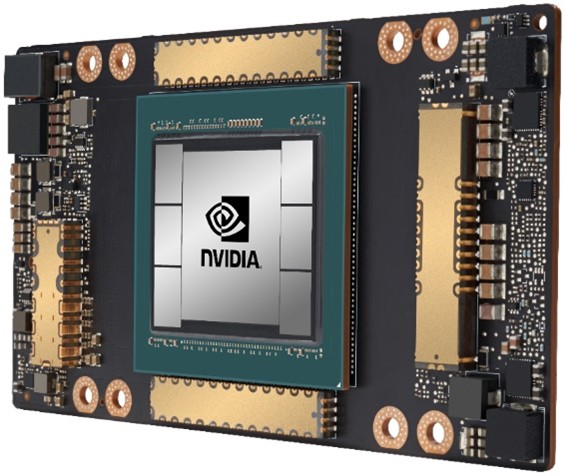

Voor kunstmatige intelligentie is met name één processor geschikt: De NVIDIA® A100 biedt versnelling zonder weerga in elk formaat op het gebied van deep learning training, deep learning inferentie, gegevensanalyses en HPC.

Met de derde generatie Tensor-rekeneenheid maakt de nieuwe Ampere-architectuur een 20-voudige prestatieverbetering mogelijk in een AI-omgeving. De nieuwe Multi-Instance-GPU (MIG) feature maakt de verdeling van de belasting tot maximaal zeven instanties mogelijk en optimaliseert deze, waardoor data science teams zo efficiënt mogelijk kunnen werken.

Een alleskunner is de NVIDIA® T4 met zijn compacte vormfactor. Deze versnellers leveren een zeer hoge dichtheid en flexibiliteit. Geoptimaliseerd voor deep learning inferentie en daarmee een ideale aanvulling op deep learning training systemen.

Op grafisch gebied levert de T4 een native gebruikerservaring voor virtuele desktops op office-gebied evenals voor virtuele workstations in het middensegment van CAD.

Om de beste prestaties mogelijk te maken voor virtuele workstations is de NVIDIA® A40 momenteel de beste keuze. Deze versneller levert genoeg prestaties voor veeleisende applicaties, zoals CAD, simulaties, VR, en maakt zelfs realtime rendering mogelijk voor een fotorealistische ervaring.

Choose the right NVIDIA Data Center GPU

Workload

| Description | NVIDIA A100 SXM4 | NVIDIA A100 PCIe | NVIDIA T4 | NVIDIA A40 |

| World's Most Powerful Data Center GPU | Versatile Data Center GPU for Mainstream Computing | World's Most Powerful Data Center GPU for Visual Computing | ||

Deep Learning Training | For the absolute fastest model training time | 8-16 GPUs | 4-8 GPUs |

|

|

Deep Learning Inference | For batch and real-time inference | 1 GPU w/ MIG | 1 GPU w/ MIG | 1 GPU |

|

HPC / AI | For scientific computing centers and higher ed and research institutions | 4 GPUs with MIG for | 1-4 GPUs with MIG for |

|

|

Render Farms | For batch and real-time rendering |

|

|

| 4-8 GPUs |

Graphics | For the best graphics performance on professional virtual workstations |

|

| 2–8 GPUs for mid-range | 4-8 GPUs for highest |

Enterprise Acceleration | Mixed Workloads – Graphics, ML, DL, analytics, training, inference | 1-4 with MIG for compute intensive | 1-4 GPUs with MIG for | 4-8 GPUs for balanced | 2-4 GPUs for graphics |

Edge Acceleration | Edge solutions with differing use cases and location |

| 1-2 GPU with MIG | 1-8 GPUs for inference | 2-4 GPUs for graphics |

Workload

| Description | NVIDIA A100 SXM4 | NVIDIA A100 PCIe |

| World's Most Powerful Data Center GPU | ||

Deep Learning Training | For the absolute fastest model training time | 8-16 GPUs | 4-8 GPUs |

Deep Learning Inference | For batch and real-time inference | 1 GPU w/ MIG | 1 GPU w/ MIG |

HPC / AI | For scientific computing centers and higher ed and research institutions | 4 GPUs with MIG for | 1-4 GPUs with MIG for |

Render Farms | For batch and real-time rendering |

|

|

Graphics | For the best graphics performance on professional virtual workstations |

|

|

Enterprise Acceleration | Mixed Workloads – Graphics, ML, DL, analytics, training, inference | 1-4 with MIG for compute intensive | 1-4 GPUs with MIG for |

Edge Acceleration | Edge solutions with differing use cases and location |

| 1-2 GPU with MIG |

Workload

| Description | NVIDIA T4 | NVIDIA A40 |

| Versatile Data Center GPU for Mainstream Computing | World's Most Powerful Data Center GPU for Visual Computing | |

Deep Learning Training | For the absolute fastest model training time |

|

|

Deep Learning Inference | For batch and real-time inference | 1 GPU |

|

HPC / AI | For scientific computing centers and higher ed and research institutions |

|

|

Render Farms | For batch and real-time rendering |

| 4-8 GPUs |

Graphics | For the best graphics performance on professional virtual workstations | 2–8 GPUs for mid-range | 4-8 GPUs for highest |

Enterprise Acceleration | Mixed Workloads – Graphics, ML, DL, analytics, training, inference | 4-8 GPUs for balanced | 2-4 GPUs for graphics |

Edge Acceleration | Edge solutions with differing use cases and location | 1-8 GPUs for inference | 2-4 GPUs for graphics |

* verplichte velden

Bekijk onze privacyverklaring die je uitgebreid informeert over onze gegevensverwerking en jouw rechten inzake gegevensbescherming.