NVIDIA –

beste Performance für die KI.

Um die Vorteile der Künstlichen Intelligenz nutzen zu können, bedarf es umfangreicher Rechenleistung. Ein leistungsstarkes System, das diesen Anforderungen gerecht wird, ist NVIDIA® DGX™. Es basiert auf der hochperformanten NVIDIA GPU-Plattform. Das Besondere: NVIDIA DGX bietet Unternehmen GPU-optimierte Software und vereinfachte Verwaltung – und das in einem kompakten System.

Die Vorteile von DGX Station und DGX Server:

Integrierte Soft- und Hardware.

Basiert auf der NVIDIA ™-Tensor Core-Technologie zur Beschleunigung von KI und HPC.

Deep-Learning-Training, Inferenz und Beschleunigung von Analysen in einem einzigen System.

Unerreichte Leistung für schnellere Iterationen und Innovationen.

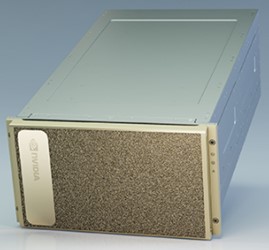

DGX im Rechenzentrum…

NVIDIA DGX™ A100 ist das universelle System für alle KI-Workloads und bietet beispiellose Rechendichte, Leistung und Flexibilität im weltweit ersten 5 petaFLOPS KI-System. NVIDIA DGX A100 verfügt über den weltweit fortschrittlichsten Beschleuniger, den NVIDIA A100 Tensor Core-Grafikprozessor, mit dem Unternehmen Trainings, Inferenz und Analysen in einer einheitlichen, einfach zu implementierenden KI-Infrastruktur mit direktem Kontakt zu NVIDIA KI-Experten konsolidieren können.

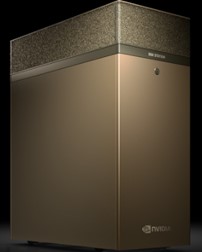

… oder DGX im Büro.

NVIDIA® DGX Station A100 ist das kompakte System im Workstation Format und bietet aktuelle Technologien, schnelle Bereitstellung und unglaubliche lokale Rechenleistung. Um Sie bei der Arbeit zu unterstützen, wurde ein flüsterleises Kühlsystem integriert und es stehen zahlreiche Tools zur beschleunigten Entwicklung zur Verfügung.

Welche Grafikprozessoren bieten die beste Leistung?

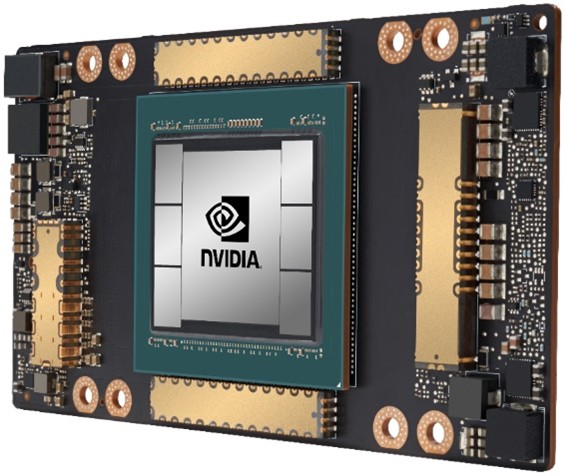

A100.

Für Künstliche Intelligenz eignet sich besonders ein Prozessor: Der NVIDIA® A100 bietet beispiellose Beschleunigung in jeder Größenordnung in den Bereichen Deep Learning Training, Deep Learning Inferenz, Datenanalysen und HPC.

Mit den Tensor-Recheneinheit der dritten Generation ermöglicht die neue Ampere-Architektur eine 20-fache Leistungssteigerung im KI Umfeld, während das neue Multi-Instance-GPU (MIG) Feature die Verteilung der Auslastung auf bis zu sieben Instanzen ermöglicht und optimiert, wodurch Data Science Teams möglichst effizient arbeiten können.

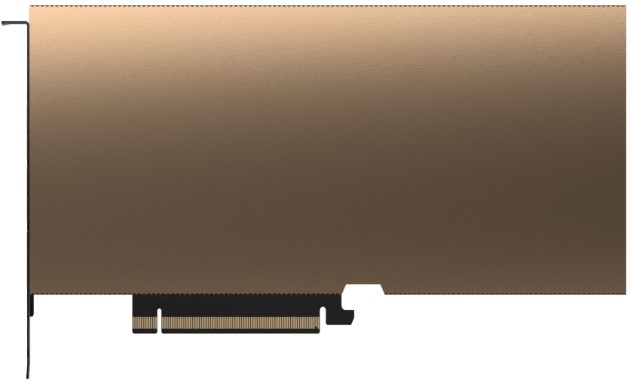

T4.

Einen Alleskönner stellt der NVIDIA® T4 mit seinem kompakten Formfaktor dar. Dieser Beschleuniger bringt eine sehr hohe Dichte und Flexibilität mit sich. Optimiert für Deep Learning Inferenz und damit eine ideale Ergänzung zu Deep Learning Training Systemen.

Im graphischen Bereich liefert der T4 ein natives Benutzererlebnis für virtuelle Desktops im Office Bereich als auch für virtuelle Workstations im mittleren CAD-Segment.

A40.

Um virtuellen Workstations die bestmögliche Performance zu ermöglichen, ist der NVIDIA® A40 die derzeit beste Wahl. Dieser Beschleuniger liefert genug Leistung für hoch anspruchsvolle Applikationen, wie CAD, Simulationen, VR und ermöglicht selbst Echtzeit-Rendering für ein fotorealistisches Ergebnis.

Choose the right NVIDIA Data Center GPU

Workload

| Description | NVIDIA A100 SXM4 | NVIDIA A100 PCIe | NVIDIA T4 | NVIDIA A40 |

| World's Most Powerful Data Center GPU | Versatile Data Center GPU for Mainstream Computing | World's Most Powerful Data Center GPU for Visual Computing | ||

Deep Learning Training | For the absolute fastest model training time | 8-16 GPUs | 4-8 GPUs |

|

|

Deep Learning Inference | For batch and real-time inference | 1 GPU w/ MIG | 1 GPU w/ MIG | 1 GPU |

|

HPC / AI | For scientific computing centers and higher ed and research institutions | 4 GPUs with MIG for | 1-4 GPUs with MIG for |

|

|

Render Farms | For batch and real-time rendering |

|

|

| 4-8 GPUs |

Graphics | For the best graphics performance on professional virtual workstations |

|

| 2–8 GPUs for mid-range | 4-8 GPUs for highest |

Enterprise Acceleration | Mixed Workloads – Graphics, ML, DL, analytics, training, inference | 1-4 with MIG for compute intensive | 1-4 GPUs with MIG for | 4-8 GPUs for balanced | 2-4 GPUs for graphics |

Edge Acceleration | Edge solutions with differing use cases and location |

| 1-2 GPU with MIG | 1-8 GPUs for inference | 2-4 GPUs for graphics |

Kontaktieren Sie uns.

*diese Felder müssen ausgefüllt werden.

Bitte beachten Sie unsere Datenschutzhinweise, die Sie umfassend über unsere Datenverarbeitung und Ihre Datenschutzrechte informieren.